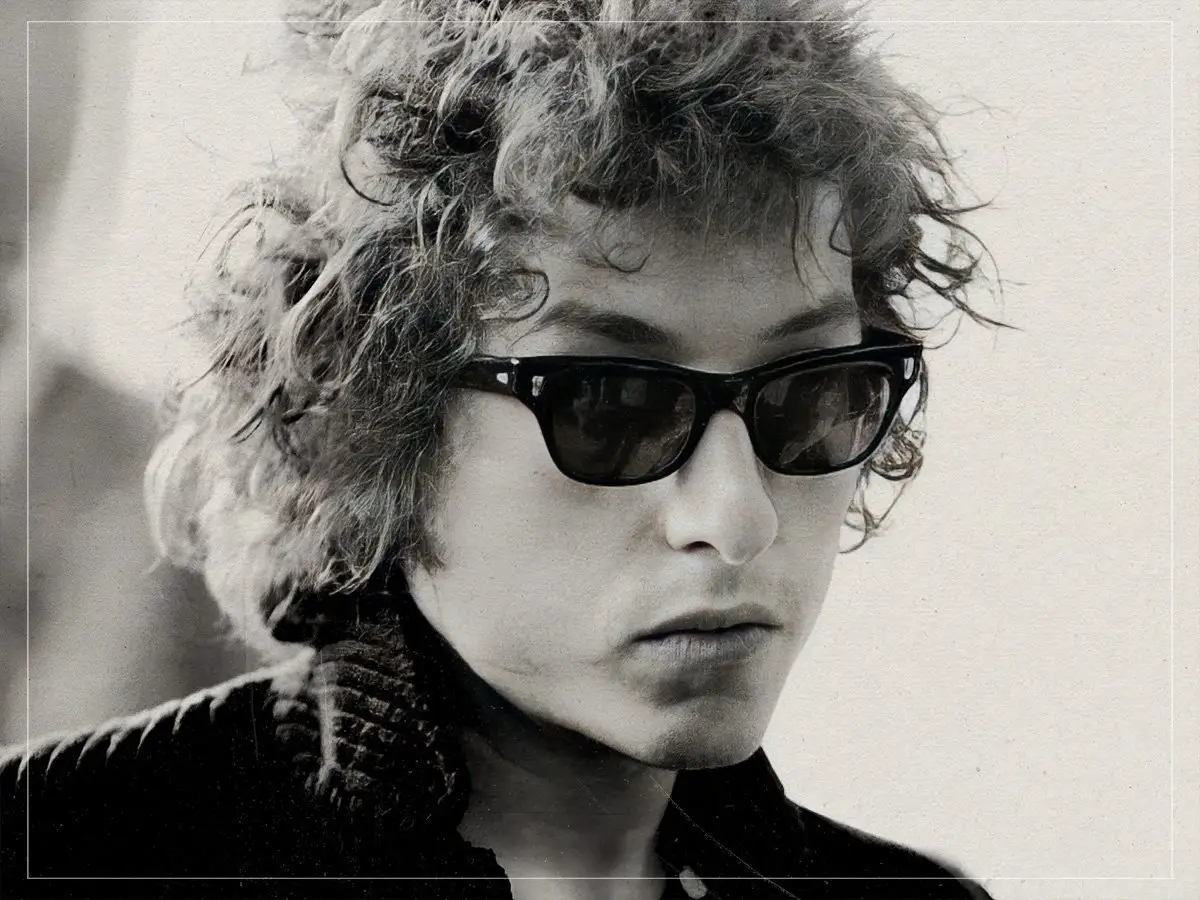

Wie man gefälschtes Kriegsmaterial nach den US-Angriffen auf iranische Atomanlagen erkennt

Demonstranten tragen Schilder und schwenken eine iranische Flagge, während sie sich am Sonntag, dem 22. Juni 2025, vor dem Weißen Haus in Washington versammeln, um gegen den US-Militärangriff auf drei Standorte im Iran am frühen Sonntag zu protestieren. (AP Photo/Jose Luis Magana)

Demonstranten tragen Schilder und schwenken eine iranische Flagge, während sie sich am Sonntag, dem 22. Juni 2025, vor dem Weißen Haus in Washington versammeln, um gegen den US-Militärangriff auf drei Standorte im Iran am frühen Sonntag zu protestieren. (AP Photo/Jose Luis Magana)Bilder und Videos von Explosionen, Bränden, Protesten und Waffen gingen nach den US-Angriffen auf drei iranische Atomanlagen am 21. Juni viral – aber viele von ihnen zeigten nicht, was tatsächlich geschah.

Stattdessen wurden sie durch aus dem Kontext gerissene künstliche Intelligenz generiert oder aus Videospielen oder Flugsimulatoren aufgezeichnet. Viele davon wurden von X-Konten mit blauen Häkchen geteilt, die früher mit Konten von Personen oder Organisationen mit verifizierter Identität verknüpft waren. (Jetzt können sie gekauft werden.)

Auf Social-Media-Plattformen kann es schwierig sein, auf den ersten Blick zu erkennen, ob die angsteinflößenden Bildunterschriften tatsächlich zu dem Foto oder Video passen, das Sie sehen. Manchmal fügen Community-Notizen-Programme jedoch Kontext hinzu manchmal nicht .

PolitiFact hat einige der irreführenden Bilder und Videos über den US-Angriff und die Reaktion darauf einer Faktenprüfung unterzogen. Hier finden Sie eine Anleitung, was Sie vermeiden sollten, und Tipps zur Überprüfung von Konfliktbildern.

KI-generierte Bilder weisen häufig visuelle Inkonsistenzen auf

Ein Blue-Check-Konto auf X namens Ukraine Front Line hat ein Video gepostet 22. Juni Das zeigt, wie ein Blitz in eine Rauchwolke einschlägt, die in einem feurigen Dunst ausbricht. Die Bildunterschrift warnte vor einem Atomkrieg: Bitte achten Sie auf den Blitz! Dies ist das sicherste Zeichen dafür, dass die Explosion tatsächlich nuklear war.

Doch das Video zeigt kein reales Ereignis. Es wurde hochgeladen 18. Juni auf YouTube mit der Überschrift ai video. Der Biografie des Kontos liest Alle Videos auf diesem Kanal werden mit künstlicher Intelligenz produziert.

Einige generative KI-Modelle ermöglichen es Menschen, Eingabeaufforderungen zu schreiben, um realistische Videos zu generieren, und die Ergebnisse werden immer ausgefeilter.

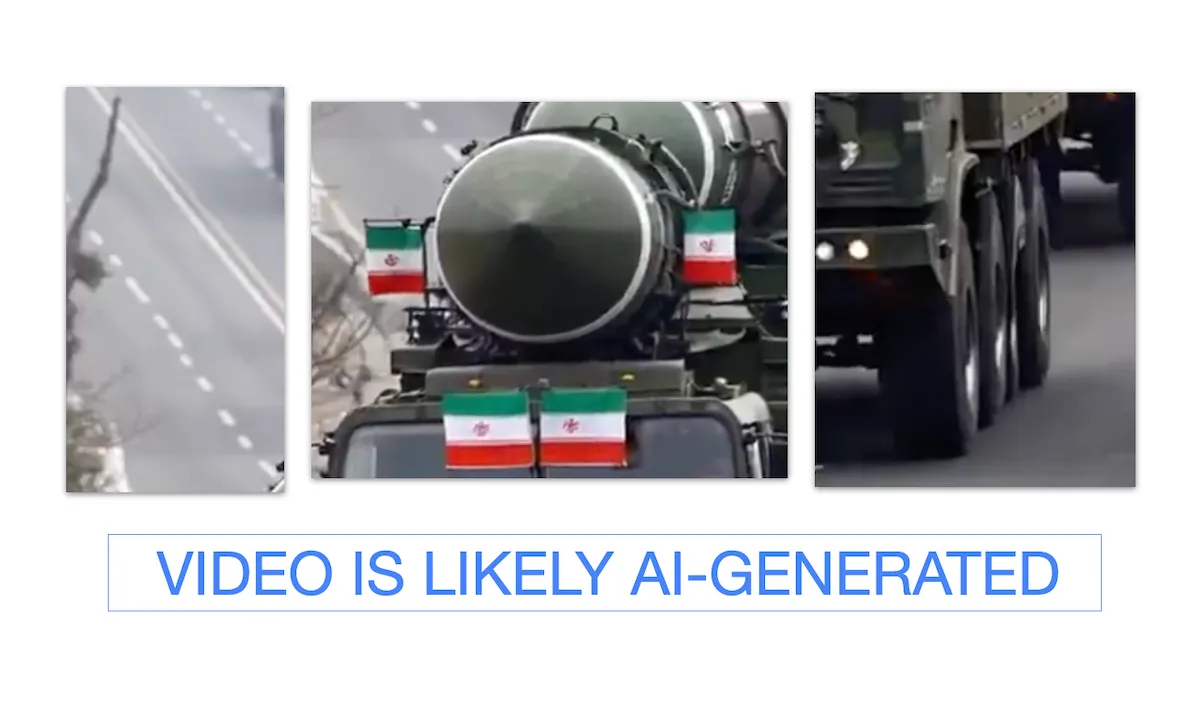

Aber sie sind nicht perfekt und ein genauer Blick auf die Videos zeigt häufig visuelle Unstimmigkeiten. Ein Video In der Bildunterschrift Getting ready for (heute night’s) Strike waren Lastwagen mit iranischen Flaggen zu sehen, die Raketen trugen. Ein genauerer Blick zeigte, dass die Linien auf der Straße uneben waren, aus dem Reifen des zweiten Lastwagens schien ein Stück herausgerissen zu sein und auch die Zeichen auf den Flaggen stimmten nicht mit der echten iranischen Flagge überein.

(Screenshots/X)

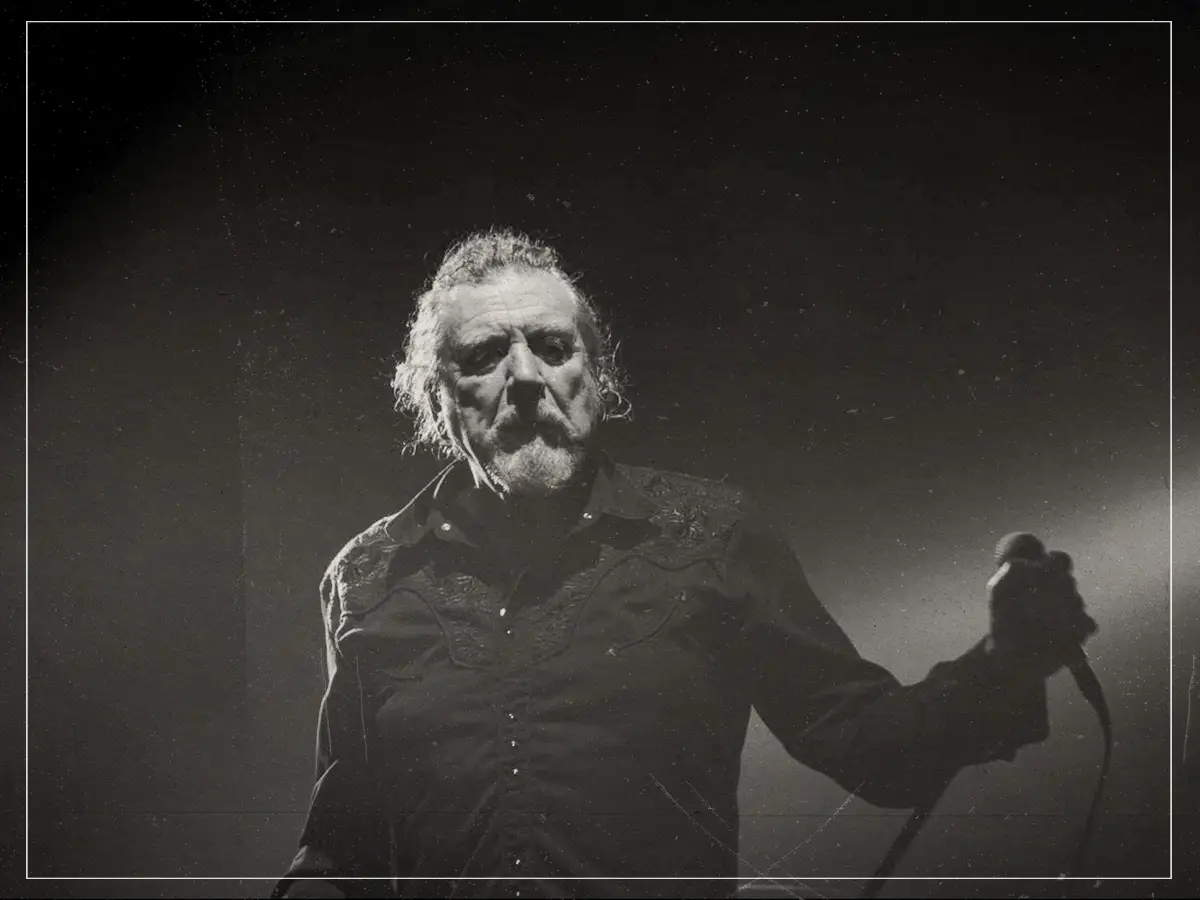

suzanne rawlings

Hany Farid, Professor an der UC Berkeley, der sich auf digitale Forensik spezialisiert hat schrieb auf LinkedIn dass viele KI-generierte Videos oft acht Sekunden oder weniger dauern oder aus zusammengeschnittenen Acht-Sekunden-Clips bestehen. Das liegt daran Bei Google sehe ich 3 Ein Text-zu-Video-Modell hat eine Begrenzung auf acht Sekunden. Einige Videos haben sichtbare Wasserzeichen, Benutzer können diese jedoch ausschneiden.

In der Vergangenheit wurden Medien falsch dargestellt prominenter als KI-Bilder bei aktuellen Nachrichtenereignissen. Aber während dieses Krieges haben sowohl pro-israelische als auch pro-iranische Berichte KI-Bilder geteilt. Emmanuelle Saliba, Chief Investigative Officer des digitalen Forensikunternehmens Get Real Labs, sagte BBC Verify Es war das erste Mal, dass generative KI während eines Konflikts in großem Maßstab eingesetzt wurde.

Fehlinformanten teilen weiterhin alte Bilder und Videos, die aus dem Kontext gerissen sind

Neben dem zunehmenden Einsatz von KI durch Fehlinformanten mangelt es nicht an Bildern und Videos, die im falschen Kontext geteilt werden.

In ganz Amerika kommt es zu Massenprotesten, als die Bürger empört auf die Straße gehen, nachdem die USA einen Angriff auf den Iran gestartet haben 22. Juni X-Beitrag lesen. Aber das Video wurde hochgeladen 14. Juni der Tag der No Kings-Proteste im ganzen Land.

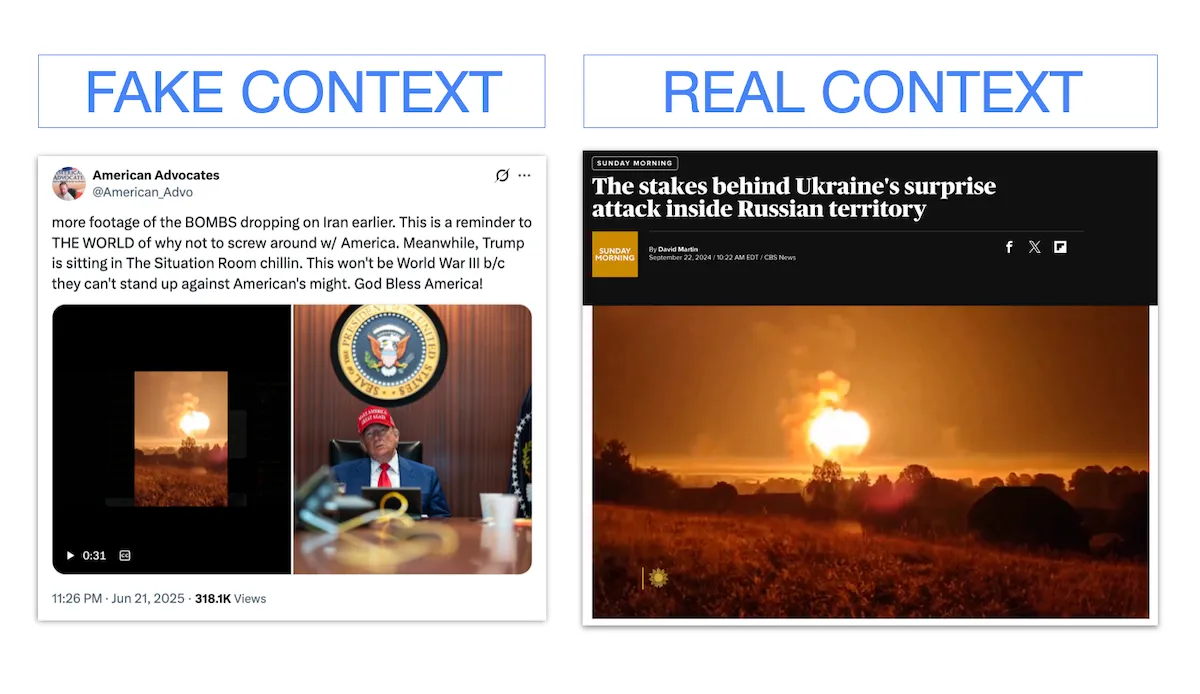

Ein weiteres X-Video, das in der Nacht der US-Angriffe geteilt wurde, zeigte eine große Feuer- und Rauchwolke. Weitere Aufnahmen der über dem Iran abgeworfenen BOMBEN finden Sie hier Videounterschrift . Aber das ist falsch; Das Video stammt aus dem Jahr 2024 Ukrainischer Angriff auf Russland .

(Screenshots/X CBS News)

Eine umgekehrte Bildersuche kann Aufschluss darüber geben, ob ein Video schon einmal online gestellt wurde und in welchem Kontext es ursprünglich stand. Tools wie Google Lens und TinEye können anzeigen, wo Bilder oder Videos plattformübergreifend geteilt wurden, wer sie gepostet hat und wann der erste Beitrag verfasst wurde. Bildunterschriften, die von Nachrichtenagenturen veröffentlicht werden, zeigen wahrscheinlich, wann und wo sie aufgenommen wurden.

posh knight

Videospielaufnahmen stammen aus den Spielbüchern früherer Konflikte

Auch Bilder aus Flugsimulatoren und militärischen Videospielen stellen den Konflikt falsch dar.

Das ist der Tarnkappenbomber B2 Spirit, der in Kalifornien startet! lies a 21. Juni X-Beitrag durch ein Blue-Check-Konto vor dem Angriff auf den Iran.

Allerdings war es kein echter B2-Bomber. Die Überprüfung des Wasserzeichens des Videos führt zu einem TikTok-Konto, das das Video gepostet hat 15. Mai mit dem Hashtag #microsoftflightsimulator ein auf Xbox verfügbares Simulationsspiel.

Gameplay aus dem Videospiel Arma ist ebenfalls vorhanden anfällig für Missbrauch während eines bewaffneten Konflikts . PolitiFact hat die Behauptungen überprüft, dass Arma-Aufnahmen während des Angriffs verwendet wurden Krieg zwischen der Ukraine und Russland und die Israel-Hamas-Krieg .

Durch Stichwortsuche auf Videoplattformen wie YouTube kann angezeigt werden, ob Videos mit zuvor hochgeladenem Videospielmaterial übereinstimmen.

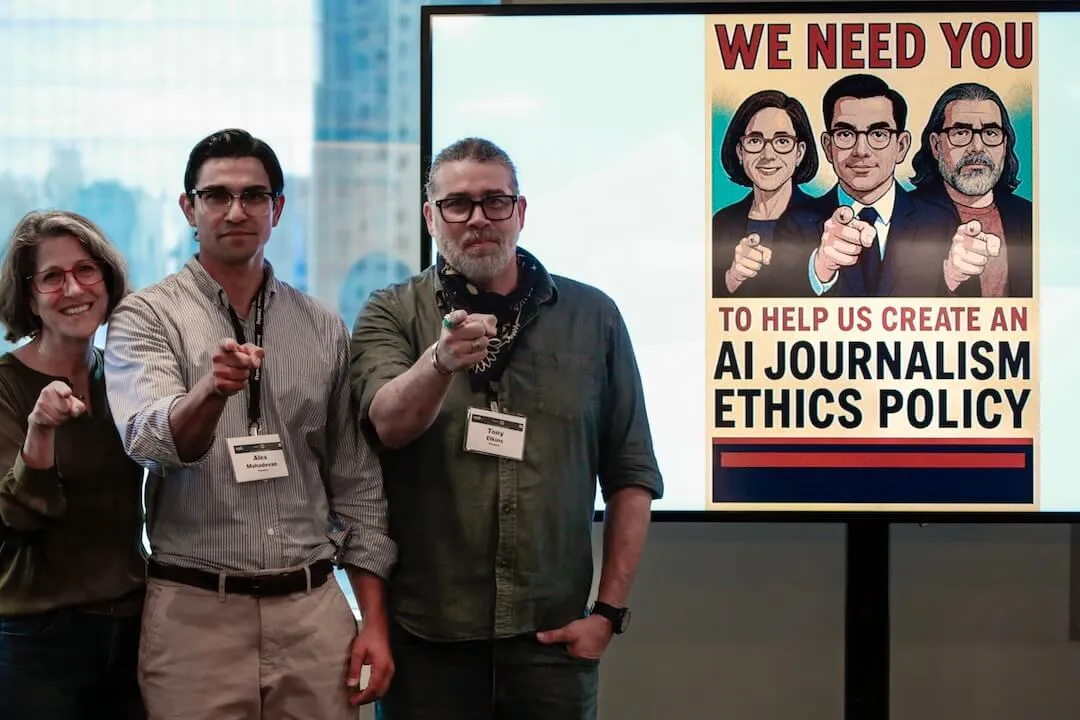

Einfache Möglichkeiten, Konten auf Vertrauenswürdigkeit zu analysieren

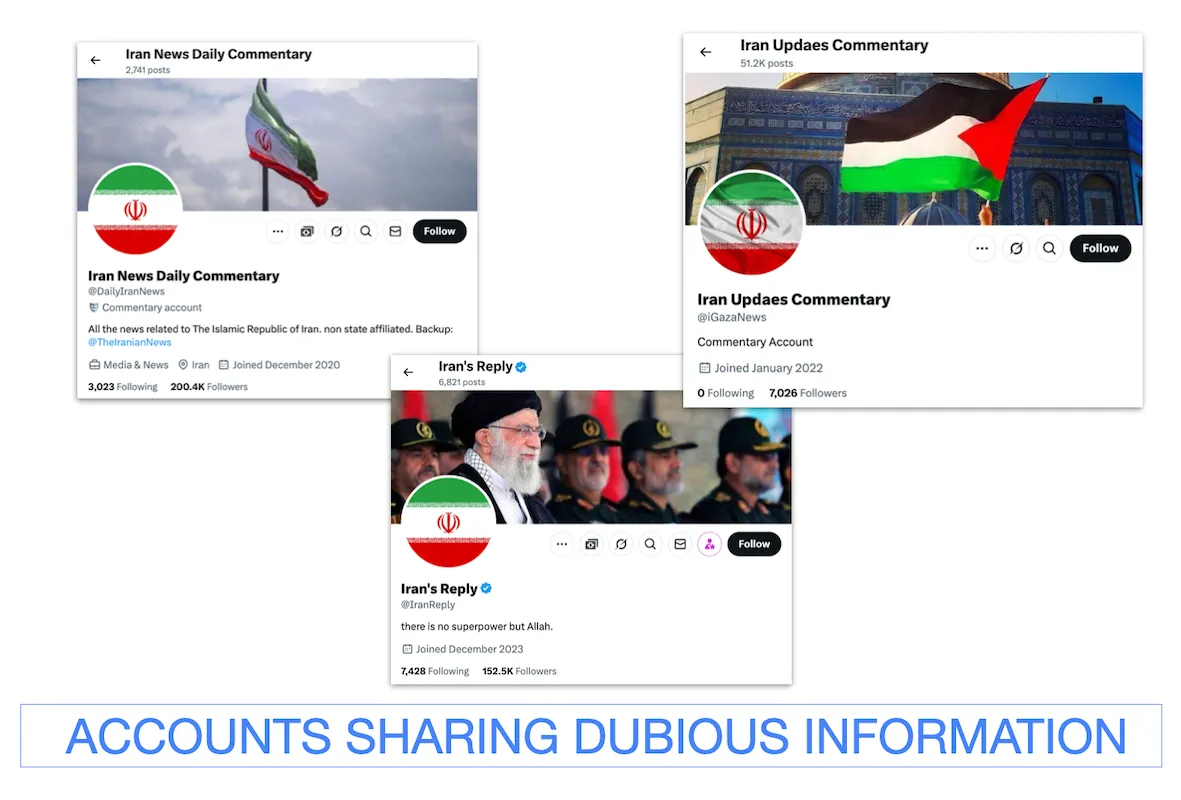

Die Überprüfung des Profils und der Biografie eines Kontos zeigt oft, ob es glaubwürdig ist oder nicht. Viele falsche und irreführende Behauptungen stammen von Konten mit der iranischen Flagge als Profilbild und Anzeigenamen, die mit legitimen Nachrichtenaktualisierungen verwechselt werden können.

Zu diesen Konten gehören Iran Updaes Commentary (Tippfehler eingeschlossen) und Iran News Daily Commentary. Ein weiteres Konto – mit einem blauen Häkchen – heißt Iran’s Reply.

(Screenshots/X)

Diese stehen jedoch nicht in Verbindung mit der iranischen Regierung oder einer glaubwürdigen Quelle. PolitiFact hat das herausgefunden Beiträge auf diesen Konten gewinnen Hunderttausende, wenn nicht Millionen Aufrufe, enthalten aber minderwertige Inhalte wie KI-generierte Bilder. Dieser Faktencheck war ursprünglich veröffentlicht von PolitiFact das Teil des Poynter Institute ist. Sehen Sie sich die Quellen für diesen Faktencheck an Hier .